Programmer des crawls avec Screaming Frog pour alimenter Data Studio

Voici comment programmer des crawls et des exports dans Google Drive avec Screaming Frog SEO.

Cette fonctionnalité de programmation de crawls fonctionne avec une licence (pour rappel, Screaming Frog est un outil SEO dont le rapport qualité/prix est quasiment imbattable).

Je vous explique ci-dessous, quels paramètres j’ai utilisés pour monitorer la quinzaine de sites de Linking Talents, dont je suis la Responsable Marketing Digital.

Créer une tâche de crawl automatisé

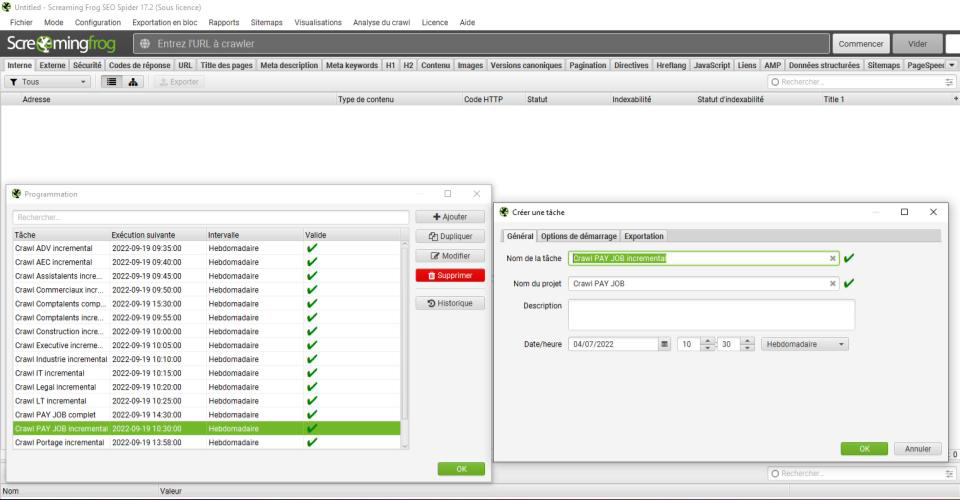

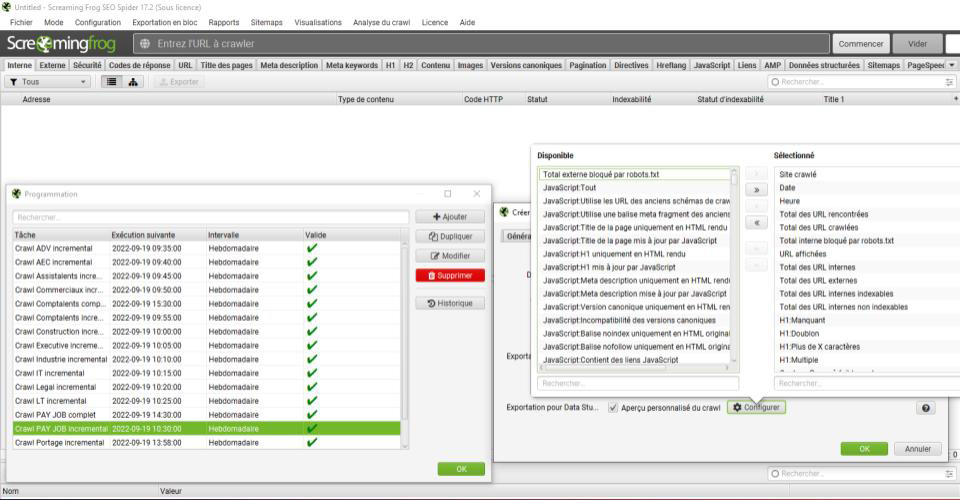

Dans fichier > Programmation, vous allez ouvrir la fenêtre de gestion des crawls automatisés.

La première chose à faire quand vous ajoutez un crawl, c’est de le nommer correctement. Le nom de la tâche va créer un dossier, lui même contenu dans un dossier portant le nom du projet. Vous pouvez donc avoir plusieurs tâches au sein d’un même projet.

Ensuite, vous choisissez la périodicité et l’heure de démarrage. Mon conseil, c’est d’espacer vos crawls pour éviter le chevauchement.

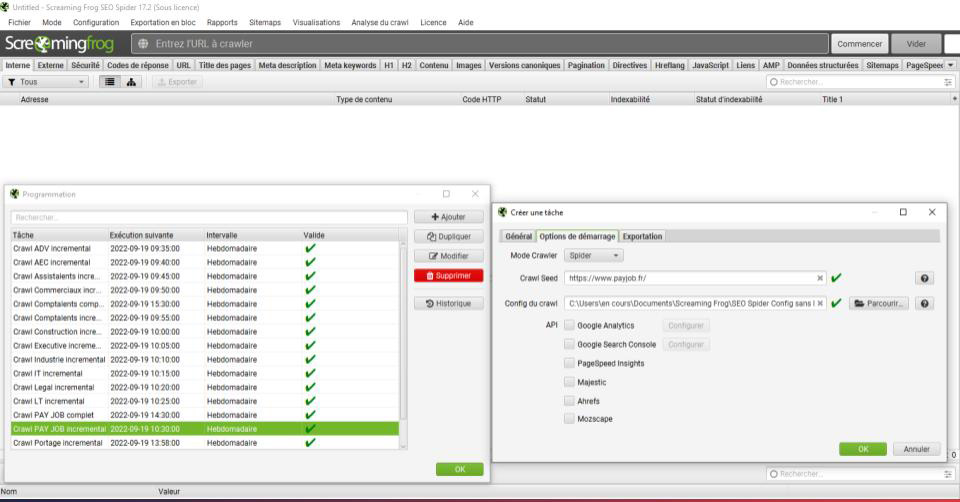

Dans l’onglet suivant, vous renseignez l’url de votre site. Ensuite, vous pouvez, si vous le souhaitez, spécifier un fichier de configuration que vous aurez préalablement enregistré. Pour ma part, j’empêche notamment l’outil de crawler les urls externes pour qu’ils ne m’agrège que des redirections onsite, par exemple.

Vous pouvez également ajouter une ou plusieurs API à ce stade : Google Anaytics, Google Search Console, Pagespeed Insights, Majestic, Ahref ou encore Mozscape. Je recommande vivement Google Search Console, car le connecteur natif permet de remonter les positions dans Data Studio, mais pas les erreurs. Certaines de ces erreurs ne sont pas détectables dans un crawl onsite, et sont donc très complémentaires : page indexées mais non envoyées par sitemap, augmentation de pages 404 non détectables onsite, etc.

Si vous souhaitez créer un rapport automatisé des Core Web Vitals par exemple, le crawl avec Pagespeed Insight est tout indiqué. Attention toutefois au délai qui s’allonge considérablement. Dans mon cas, un crawl avec cette API prend jusqu’à 45 minutes, alors que sans, c’est plutôt 2 ou 3 minutes.

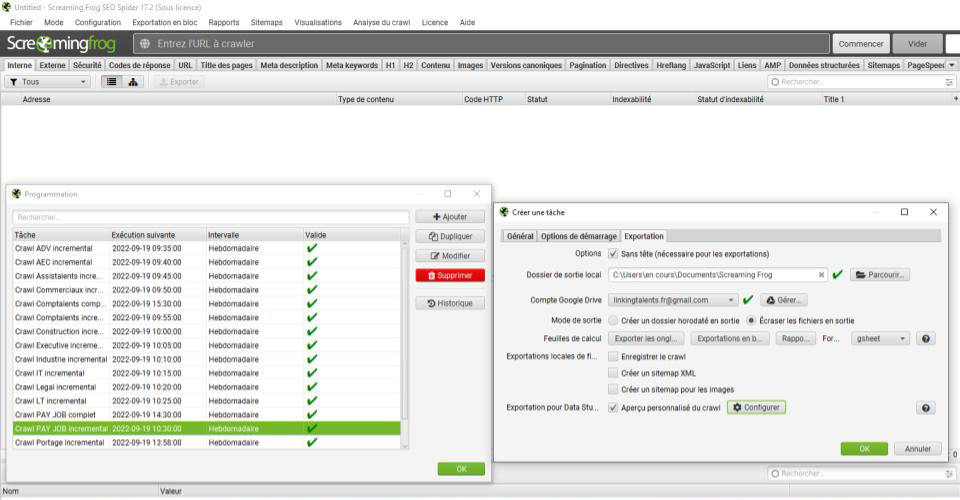

C’est dans le dernier onglet que le choix va être fait entre export incrémental et export complet. Dans tous les cas, vous devez cocher la case Sans tête, en haut de la fenêtre, pour débloquer les paramètres suivants.

Vous pouvez ensuite spécifier un dossier de votre PC pour enregistrer le crawl en local. Mais plus important pour notre cas, vous allez connecter votre compte Google et cocher : Écraser les fichiers en sortie. Cela permettra de mettre à jour le fichier que vous aurez préalablement connecté à Google Data Studio, que ce soit un crawl incrémental ou complet.

Programmer un crawl incrémental avec Screaming Frog SEO

Pour agréger le nombre d’erreurs rencontrées avec un horodatage, c’est la dernière case qu’il faut cocher : Exportation pour Data Studio. Vous allez ensuite cliquer sur Configurer, et vous pourrez ainsi choisir quels KPIs vous souhaitez monitorer, en les faisant passer dans la fenêtre de droite.

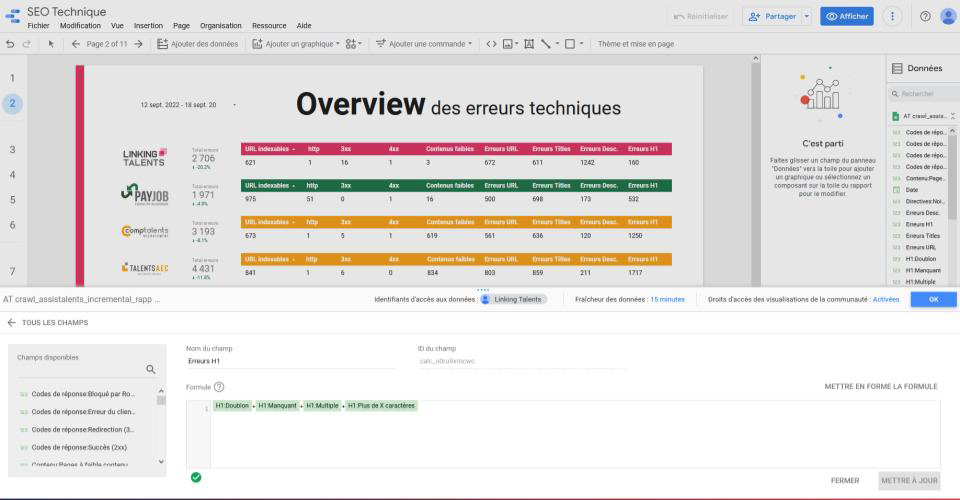

La programmation d’un crawl incrémental permet de monitorer sur une seule interface l’état de santé technique de vos sites. Vous pouvez créer des formules qui additionnent toutes les erreurs d’un même type pour plus de lisibilité. J’ai également opté pour une somme totale des erreurs, comparée à la période précédente (semaine passée en l’occurence). C’est ce KPI qui me permet, une fois par semaine, de me dire sereinement qu’il n’y a pas d’alerte (dans le cas présent, juste les erreurs connues qui attendent de la bande passante des développeurs). Par contre, le jour où vous observer +50 % d’erreurs, il faut tout de suite chercher ce qui a été modifié sur le site et faire un correctif le plus rapidement possible.

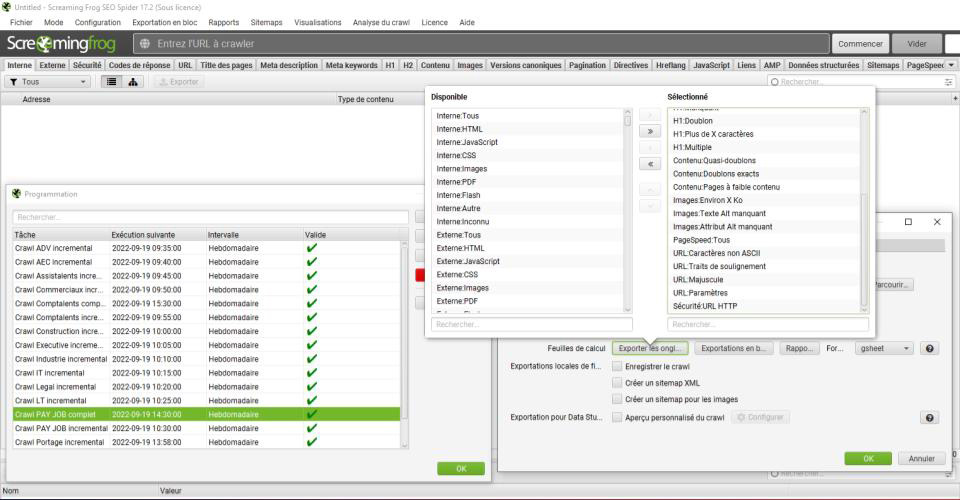

Programmer un crawl complet avec Screaming Frog SEO

Un crawl complet peut avoir plusieurs intérêts :

- Votre client a ses propres rédacteurs et régulièrement il faut checker les Titles, Descriptions, H1, etc. : vous pouvez lui remonter dans un dashboard les urls concernées pour qu’il corrige au fur et à mesure. ;

- Vous souhaitez automatiser vos audits techniques ;

- Vous souhaitez monitorer certains aspects techniques pour vérifier la santé de votre site dans la durée.

Dans l’exemple ci-après, j’ai mis en place un crawl complet des KPIs de Pagespeed Insights, pour monitorer les Core Web Vitals.

Déjà, parlons de la différence avec un crawl incrémental. Il faut cliquer sur Exporter les onglets (et non pas sur l’exportation pour Data Studio). Le choix des KPIs se fait le la même manière.

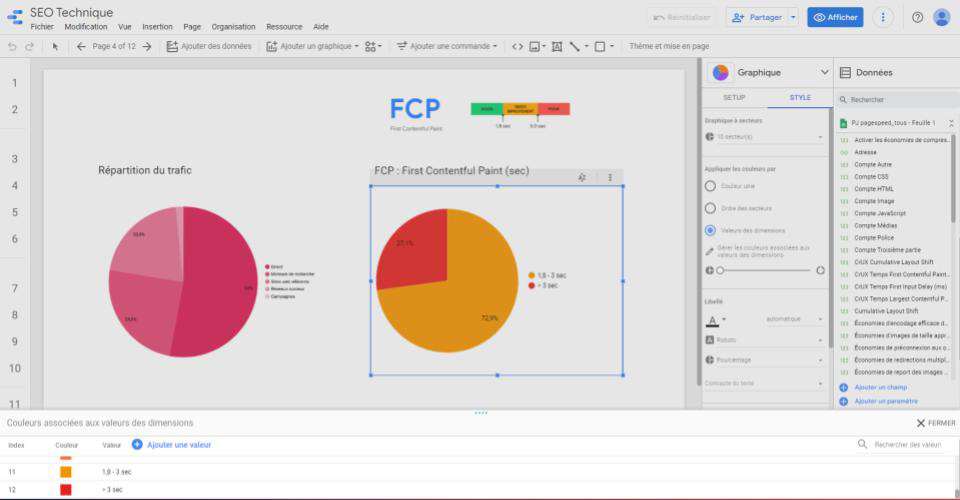

Voici le type de vue que vous pouvez construire dans Google Data Studio après avoir connecté vos fichiers Google Sheet. Attention ce travail est artisanal et chronophage. Ne connectez en crawl complet que ce qui est vraiment pertinent pour votre usage.

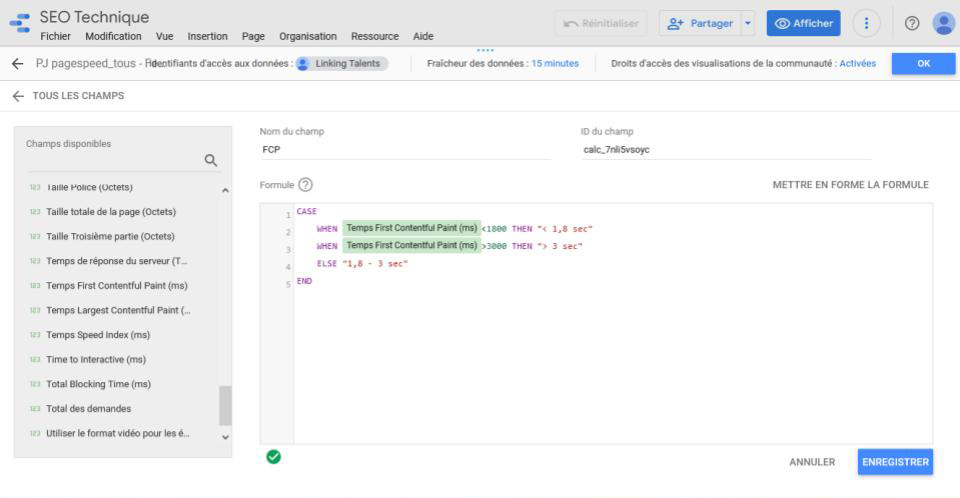

Pour créer la vue précédente, j’ai utilisé une formule conditionnelle (CASE). C’est la formule essentielle pour regrouper des données, et ainsi évité un camembert avec +1 000 parts, qui serait illisible.

Dans le cas présent, j’ai suivi les indicateurs associés à ce que Google considère comme bon, moyen et mauvais.

Cette dernière capture, est un petit point de Data Art. Si dans bien des cas, utiliser les couleurs de votre charte graphique comme couleur unie dégradée suffit à créer un dashboard à votre image (exemple de gauche), dans le cas des Core Web Vitals, la couleur a de l’importance. L’association de couleurs aux valeurs des dimensions permet d’attribuer respectivement du vert au bon, du orange au moyen et du rouge au mauvais. Ce code couleur est très explicite et permet de voir en un rapide coup d’oeil la tendance.

Attention toutefois à l’utilisation des couleurs comme seul indicateur quand vous pouvez être amené à partager votre travail avec quelqu’un de daltonien. Il peut être opportun de conserver la légende en plus.

Que faire si votre crawl ne se lance pas ?

Partant du principe que vous avez tout bien configuré, j’ai remarqué que mon PC ne lance pas le crawl lorsqu’il est sur batterie. Il est donc préférable de provilégier une alimentation sur secteur. Et bien évidemment, votre PC doit être allumé : lundi ferié et PC éteint signifient que votre crawl ne s’exécutera pas !

Pour aller plus loin

Certains profils techniques de la communauté SEO n’hésitent pas à connecter les crawls à BigQuery. Vous pouvez également creuser cette solution si vous maitrîsez l’outil ou souhaitez prendre le temps de vous y former.

Voir aussi l’article de Screaming Frog : How to automate a crawl reports in Data Studio.